Réaliser de l’A/B testing directement via Google Tag Manager (GTM) offre des avantages précieux pour les professionnels chevronnés du web analytics, de la conversion et du marketing digital : flexibilité dans l’implémentation, coût limité (souvent « gratuit » en licence), rapidité de mise en œuvre.

Cet article s’adresse à un public déjà familier avec GTM et les principes de base de l’A/B testing.

Nous allons détailler : les outils nécessaires, les types d’éléments à tester, la méthodologie technique complète pour déployer un test via GTM, les erreurs à éviter.

Et enfin : pourquoi coupler GTM avec un outil SaaS comme Webyn peut maximiser les performances et la fiabilité des tests ?

Quels outils pour faire de l’A-B testing avec Google Tag Manager ?

Mettre en place un test A/B avec Google Tag Manager (GTM) nécessite quelques ressources clés, mais offre une flexibilité rare pour les équipes techniques et marketing.

GTM permet d’injecter du code, de modifier le DOM (Document Object Model) et de suivre les comportements sans passer par le déploiement du site. C’est une solution idéale pour tester rapidement des hypothèses, notamment lorsque l’on maîtrise déjà l’écosystème Google et le suivi analytique.

Pour commencer, trois prérequis sont indispensables :

- Un accès complet à GTM, avec les droits de création de balises, variables et déclencheurs ;

- Un outil d’analyse (GA4 ou équivalent) pour mesurer les conversions par variante ;

- Un éditeur de code JavaScript, pour personnaliser la logique de randomisation et les modifications visuelles.

Des outils complémentaires viennent renforcer la fiabilité du dispositif : gestion des cookies ou du localStorage pour persister la version vue par l’utilisateur, scripts de génération aléatoire pour répartir le trafic, et outils de suivi comportemental comme Webyn ou Microsoft Clarity pour enrichir l’analyse qualitative.

GTM seul ou couplé à d’autres outils : avantages et limites

Utiliser GTM seul permet de concevoir un système de test entièrement personnalisé : gratuit, flexible et rapide à mettre en place.

En revanche, la maintenance peut devenir lourde : gestion manuelle du code, suivi des statistiques, analyse de la significativité…

C’est là qu’un outil SaaS comme Webyn complète parfaitement GTM. Webyn centralise la gestion des expériences, automatise les calculs statistiques et la segmentation, et simplifie le reporting. En combinant la puissance de déploiement de GTM et les capacités analytiques d’un outil dédié, les équipes gagnent à la fois en vitesse d’exécution et en fiabilité des résultats. Une approche idéale pour structurer un programme d’expérimentation à grande échelle.

Bénéfices d’un SaaS comme Webyn

- Gestion centralisée des tests (création, suivi, versioning).

- Analyse statistique intégrée : calculs de significativité, rapports prêts à l’usage.

- Segmentation avancée : par typologie d’utilisateurs, par canal, par source.

- Déploiement plus rapide des expériences complexes (multi-pages, personnalisations avancées) tout en conservant GTM comme levier de déploiement de script.

Scénario de couplage

On utilise GTM pour déployer la balise du test (Custom HTML ou snippet Webyn), puis l’outil Webyn gère la logique de variante, les audiences, le suivi, et GTM se charge uniquement du déclenchement et de l’enregistrement.

L’avantage : rapidité d’implémentation + robustesse de l’analyse.

Quels éléments peut-on tester efficacement avec GTM ?

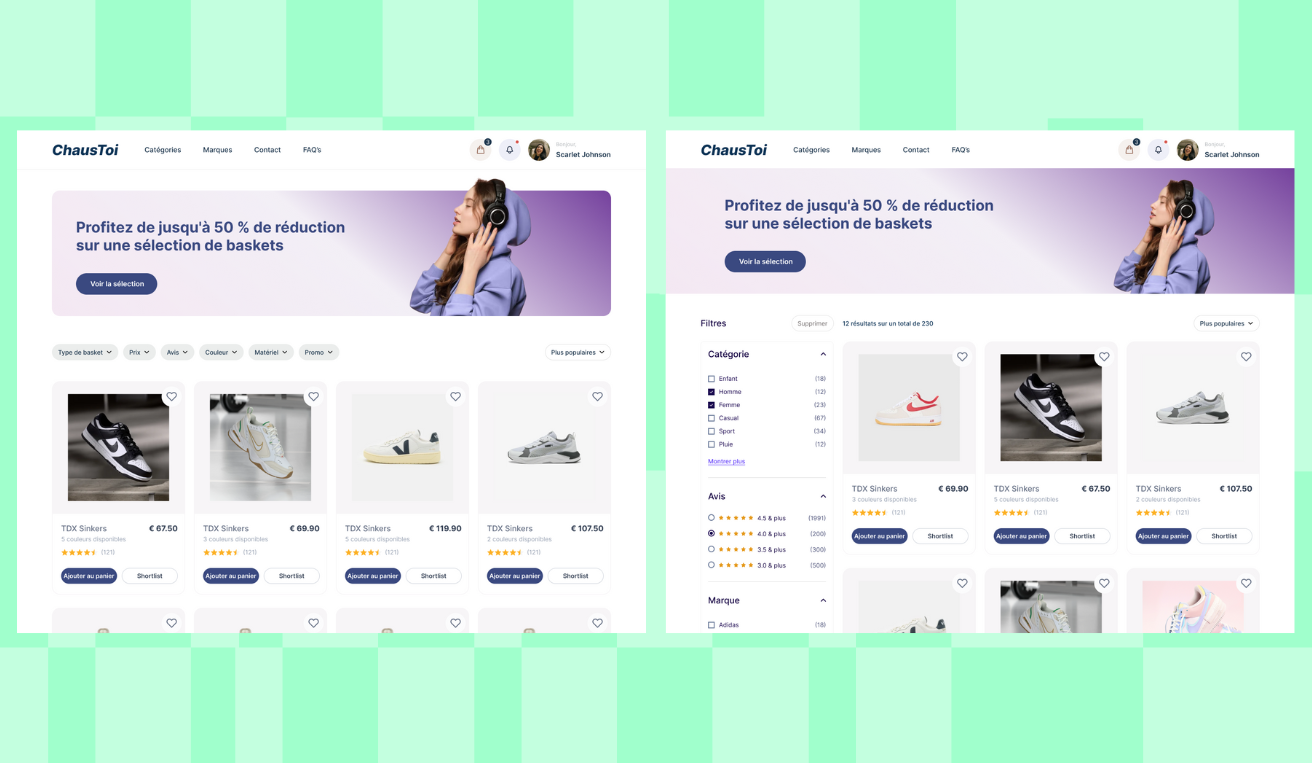

Google Tag Manager offre une grande liberté pour modifier le contenu d’un site à la volée et tester différentes variantes sans intervention côté serveur. L’A/B testing via GTM repose sur des modifications JavaScript et CSS appliquées dynamiquement au chargement de la page, ce qui le rend idéal pour tester des éléments visuels ou textuels à fort impact sur la conversion.

Les modifications les plus courantes concernent les textes et les appels à l’action : ajuster le wording d’un bouton (« Acheter maintenant » vs « Ajouter au panier »), tester un titre de page ou un message promotionnel.

On peut également faire varier les visuels (images de produits, bannières, couleurs d’arrière-plan) ou la structure d’une section ; par exemple, l’ordre des blocs, la taille d’un formulaire ou la présence d’un bandeau de réassurance.

Cibler ces éléments passe par l’utilisation de sélecteurs CSS ou d’identifiants HTML dans GTM. Une balise Custom HTML ou JavaScript personnalisé injecte alors la modification uniquement pour la variante attribuée à l’utilisateur.

Il faut cependant connaître les limites de cette approche : les tests server-side sont impossibles, et les changements trop profonds peuvent impacter la performance ou créer un effet de flicker (affichage temporaire de la version originale avant modification).

Pour approfondir les idées de tests à forte valeur ajoutée, consultez notre article dédié sur les idées d’A/B tests pour sites e-commerce, qui présente des exemples concrets de scénarios performants.

Comment mettre en place une stratégie d’A/B testing avec Google Tag Manager ?

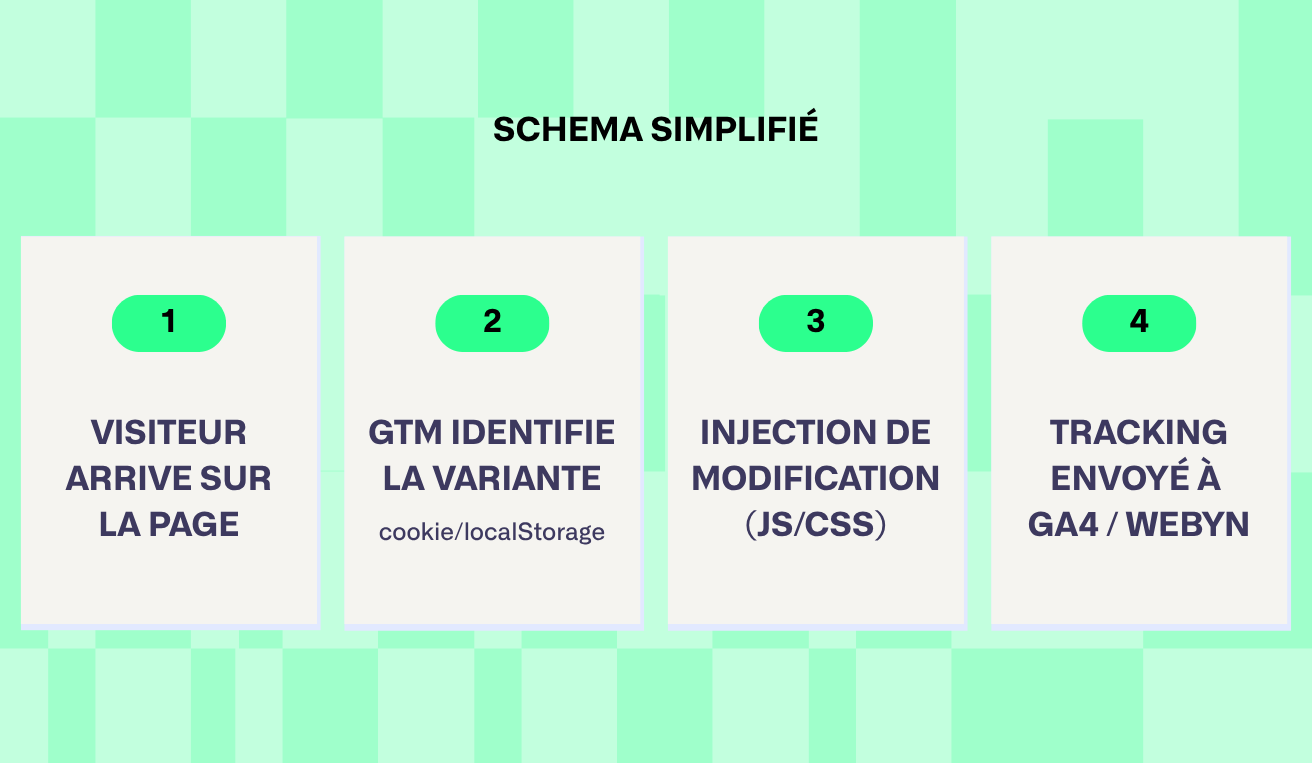

Pour qu’un A/B test via GTM produise des insights exploitables, il faut une méthode reproductible : définir l’hypothèse, répartir le trafic de façon robuste, persister l’attribution, tracker correctement, et analyser la significativité. GTM servira de couche de déploiement côté client, en coordination avec votre analytics (ex. GA4) et outils qualitatifs (Hotjar, Clarity). Nous vous conseillons de lire notre guide sur la construction d'une roadmap d'AB testing.

Configurer la randomisation et l’attribution des variantes

Créez une variable JavaScript personnalisée dans GTM qui génère un entier aléatoire (0–99) pour chaque nouvel utilisateur :

function() {

var bucket = Math.floor(Math.random()*100);

return bucket;

}Mappez ensuite la valeur sur vos variantes (ex. 0–49 = contrôle, 50–99 = variante A) via une table de correspondance (RegEx table / Lookup Table).

À la première attribution, stockez la valeur dans un cookie ou localStorage (ex. experiment_checkout=variantA) pour assurer la persistance et éviter le re-bucketting.

Définissez la durée d’expiration du cookie en fonction de la durée de l’expérience (souvent 30 jours).

Toujours prévoir un fallback : si ni cookie ni localStorage n’est présent, régénérer et réécrire.

Déployer et cibler dynamiquement les modifications

Créez une balise Custom HTML pour chaque expérience qui s’exécute uniquement si la variable « version » correspond à la variante.

Exemple minimal :

if (localStorage.getItem('experiment_checkout') === 'variantA') {

var el = document.querySelector('#cta-button');

if (el) el.textContent = 'Commander maintenant';

}Utilisez des déclencheurs précis (Page View — DOM Ready ou Event spécifique) et gérez l’asynchronicité du DOM via MutationObserver ou vérifications répétées (setInterval avec timeout) pour éviter le flicker.

Testez chaque script en staging et via Chrome DevTools vérifiez :

- les performances,

- erreurs console,

- et absence d’impact sur l’accessibilité.

Enfin, documentez la balise, son déclencheur et sa dépendance (CSS selector, ID).

Suivi, analyse et reporting des résultats

Après attribution, envoiez un événement à GA4 (ou autre) avec un paramètre variant pour chaque action clé (clic CTA, ajout panier, conversion) :

- Evénement GA4 : cta_click_test { variant: 'A' }

- Créez une dimension personnalisée “version_experiment” pour segmenter rapports et audiences.

- Surveillez les KPI principaux (taux de conversion, valeur panier, temps sur page) et les signaux secondaires (bounce, erreurs JS).

Utilisez un calculateur de significativité (p < 0,05) ou un outil intégré (ex. Webyn) pour vérifier si la différence est fiable — vérifie aussi la puissance statistique (target power ≥ 80%).

Pensez à segmenter par device, canal et nouveau vs récurrent pour détecter des effets hétérogènes.

Terminez toujours par une phase de documentation :

- hypothèse,

- durée,

- trafic,

- résultats chiffrés,

- décision (déployer / itérer / abandonner).

Cela crée une bibliothèque d’expériences exploitables sur le long terme.

Les erreurs courantes à éviter lors de l’A-B testing avec GTM

Mettre en place un test A/B via Google Tag Manager peut sembler simple, mais plusieurs pièges techniques et méthodologiques peuvent fausser les résultats ou dégrader l’expérience utilisateur.

Pour aller plus loin, vous pouvez consulter notre article dédié aux erreurs fréquentes en A/B testing, ainsi que notre e-book complet sur le guide de l’A/B testing.

La première erreur concerne la randomisation et la persistance des variantes. Un cookie mal positionné, un script déclenché trop tôt ou un localStorage non vérifié peuvent entraîner un re-bucketting, où un utilisateur change de version entre deux visites.

Résultat : un test statistiquement inutilisable.

La seconde erreur touche à la manipulation du DOM. Si la modification s’exécute trop tard ou dépend d’un élément chargé de manière asynchrone, elle crée un effet de flicker : l’utilisateur voit brièvement la version originale avant la variante. Outre l’impact UX négatif, ce clignotement introduit un biais comportemental.

Troisième écueil : l’absence de tracking fiable. Sans dimension personnalisée permettant d’identifier la version affichée, les données ne peuvent pas être segmentées correctement. Un test sans segmentation revient à mesurer deux échantillons mélangés, impossible d’en tirer des conclusions fiables.

Quatrième erreur : le non-respect de la durée minimale d’exposition.

{{cta:|Stopper un test dès que la courbe semble favorable conduit souvent à un faux positif statistique. Un test doit atteindre une taille d’échantillon suffisante et une puissance statistique minimale.}}

Enfin, il faut prendre en compte les risques SEO et accessibilité : modifications trop lourdes, ralentissements induits par des scripts répétés ou altération du balisage.

Et, en cas d’anomalie, toujours prévoir un rollback immédiat via un simple arrêt de la balise ou une variable de sécurité.

Pourquoi utiliser un outil SaaS spécialisé comme Webyn en complément de GTM ?

GTM permet de déployer rapidement des scripts d’expérimentation, mais sa logique « maison » atteint vite ses limites dès que le volume de tests augmente ou que les scénarios se complexifient. Un outil SaaS comme Webyn vient structurer, automatiser et fiabiliser l’ensemble du programme d’A/B testing.

[cta-webyn]

La première valeur ajoutée réside dans la centralisation du pilotage : toutes les expériences, leurs configurations, leurs variantes et leurs rapports sont réunis dans un même espace, ce qui réduit le temps de maintenance et évite la dispersion entre balises GTM, feuilles de calcul et dashboards multiples.

Webyn fournit également une segmentation avancée, une gestion des audiences plus fine et un calcul automatique de la significativité, éléments essentiels pour garantir que les décisions reposent sur des données fiables. La plateforme limite aussi les risques d’erreur humaine grâce à une meilleure traçabilité et un historique complet des tests.

Pour des parcours plus complexes, tests multi-pages, test multivariés ou scénarios de personnalisation, Webyn accélère le déploiement tout en renforçant la sécurité.

Plusieurs marques ont utilisé GTM pour charger les scripts Webyn, tandis que Webyn gérait la logique, la randomisation et le reporting, réduisant ainsi considérablement la charge technique côté équipe.

FAQ

Peut-on réaliser des tests multi-variants (A/B/C…) avec GTM ?

Oui, mais cela demande une configuration plus avancée. GTM peut gérer plusieurs variantes en créant une table de correspondance plus large (ex. 0–33 = A, 34–66 = B, 67–99 = C) et en stockant la valeur dans un cookie ou le localStorage.

Cependant, plus le nombre de variantes augmente, plus la logique de maintenance, le volume d’échantillon requis et la complexité du tracking s’accroissent.

Dans ces cas, une plateforme spécialisée comme Webyn simplifie considérablement la gestion des segments, des scripts et du reporting.

L’A/B testing avec GTM impacte-t-il le SEO ?

Indirectement, cela peut arriver. Comme GTM agit côté client, les modifications ne sont pas visibles par les moteurs de recherche au moment du crawl, ce qui limite les risques d’un point de vue contenu.

En revanche, des scripts mal optimisés peuvent augmenter le temps de chargement, provoquer du flicker ou introduire des erreurs de rendu. Ces effets techniques peuvent avoir une incidence sur l’expérience utilisateur et donc, à terme, sur la performance SEO. Une bonne pratique consiste à limiter les tests sur des éléments critiques, optimiser le JavaScript injecté et utiliser des déclencheurs précis.

Comment s’assurer que les résultats d’un test GTM sont statistiquement fiables ?

La fiabilité repose sur trois piliers :

- Une randomisation correcte et persistante, sans re-bucketting.

- Un volume d’échantillon suffisant, avec une durée d’exposition minimale.

- Une analyse statistique rigoureuse pour vérifier la significativité (p-value, intervalle de confiance, puissance statistique).

Pour valider vos résultats, utilisez un calculateur de significativité dédié. Une plateforme comme Webyn peut automatiser cette étape pour éviter les erreurs d’interprétation.

.svg)

.svg)