L’A/B testing est devenu un pilier incontournable de l’optimisation de l’expérience utilisateur et de la conversion. Pourtant, même les équipes les plus expérimentées tombent régulièrement dans des pièges qui biaisent les résultats et mènent à des décisions contre-productives.

Cet article revient sur 9 erreurs d’A/B testing à éviter absolument. Les identifier et les corriger permet de fiabiliser vos expérimentations, d’exploiter pleinement le potentiel de chaque test et de transformer vos initiatives en véritables leviers de croissance e-commerce.

1. Ne pas formuler d’hypothèse claire pour chaque test

Un A/B test n’a de valeur que s’il repose sur une démarche scientifique. Sans hypothèse précise, fondée sur des données, il s’apparente à un tirage au sort qui mène facilement à des conclusions arbitraires.

La première étape consiste à identifier un problème réel à partir de l’analyse quantitative (taux de clic, taux de conversion, abandon panier) et qualitative (enquêtes, verbatims, feedbacks). Repérer un point de friction dans le parcours utilisateur est indispensable pour formuler une hypothèse pertinente.

Une hypothèse solide doit être mesurable et reliée à un objectif business. Par exemple :

- Trop vague : “Raccourcir le formulaire améliorera l’expérience utilisateur.”

- Plus solide : “En réduisant le formulaire de paiement de 5 à 3 champs, nous estimons pouvoir diminuer le taux d’abandon de 20 % sur desktop et augmenter la validation du paiement.”

Sans ce cadre, l’interprétation devient floue : une variation qui “gagne” ne permet pas toujours de comprendre pourquoi elle fonctionne ni si le résultat peut être généralisé. À l’inverse, une hypothèse claire sert de grille de lecture, facilite l’apprentissage et alimente une logique d’amélioration continue.

S’appuyer sur les données pour bâtir son hypothèse

Les meilleures hypothèses se construisent en croisant données quantitatives et qualitatives :

- Analytics : repérez les étapes sous-performantes du tunnel (rebond élevé sur une page produit, abandon massif au checkout).

- Heatmaps et recordings : observez où les utilisateurs bloquent ou cliquent inutilement.

- Feedback client : mettez en perspective comportements et motivations à travers les verbatims

Cette approche permet de hiérarchiser les tests selon leur impact potentiel et de transformer l’A/B testing en un processus structuré et cumulatif, directement relié aux objectifs business.

2. Lancer des tests trop complexes ou mal priorisés

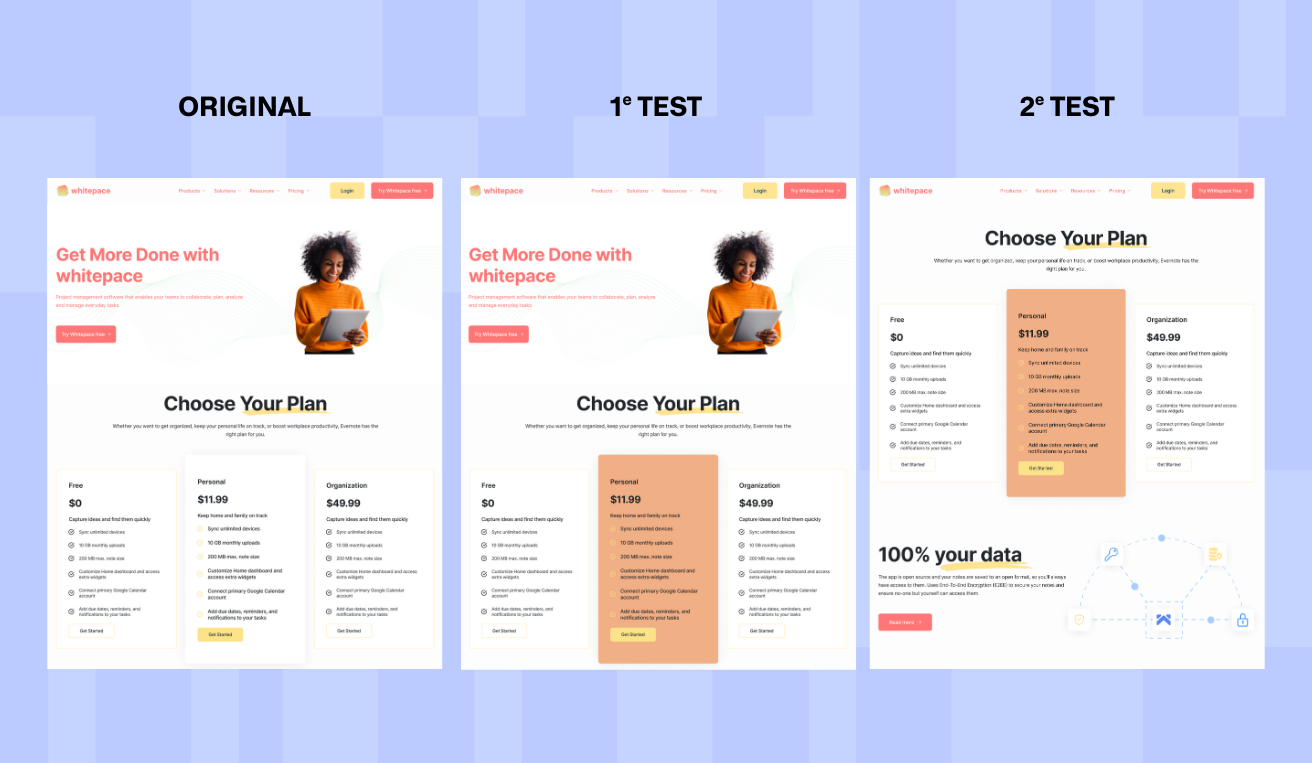

Un autre piège fréquent consiste à vouloir aller trop vite en lançant des tests ambitieux dès le départ : multiples variations, refontes complètes ou parcours entièrement revisités. Ces projets demandent du temps, mobilisent des ressources importantes et produisent souvent des résultats difficiles à analyser.

{{cta:Le risque est double :|d’un côté, les résultats sont difficiles à interpréter; de l’autre, les équipes se découragent face à des projets longs, coûteux et rarement concluants.}}

Mieux vaut commencer par des tests simples, ciblant un élément précis : un titre, un visuel, un bouton d’appel à l’action, l’ordre des informations. Ces expérimentations rapides et lisibles génèrent des apprentissages immédiats et évitent de décourager les équipes.

La multiplication de variables ou de tests simultanés entraîne aussi une dilution statistique : plus il y a de scénarios, plus il faut de trafic pour obtenir une significativité correcte. Les durées s’allongent, l’analyse devient confuse et la fiabilité diminue.

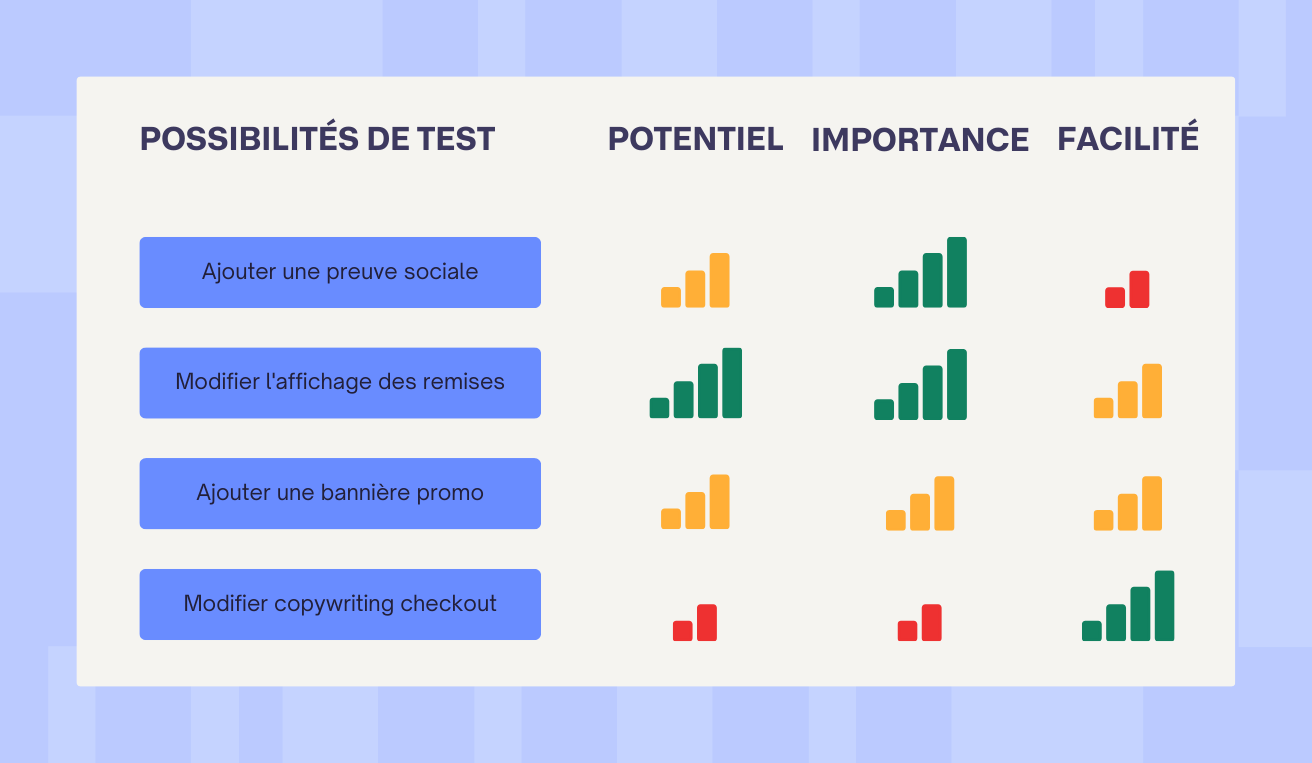

La solution réside dans la priorisation. Des frameworks comme PIE (Potential, Importance, Ease) ou ICE (Impact, Confidence, Ease) aident à comparer les hypothèses et à concentrer l’énergie sur les tests au meilleur rendement. Il est également stratégique de privilégier les pages à fort trafic ou à forte valeur business (produits phares, panier, checkout), plutôt que de disperser les efforts sur des zones secondaires.

Définir une roadmap de tests et un process rigoureux

Un programme d’A/B testing performant ne repose pas sur une suite de tests improvisés, mais sur une roadmap structurée.

- Établir un calendrier de tests avec des objectifs et indicateurs définis ;

- Impliquer les parties prenantes (marketing, produit, IT) pour aligner les priorités ;

- Limiter le nombre de tests simultanés pour éviter les interférences.

Ce cadre méthodique maximise la fiabilité des résultats, valorise le travail des équipes et transforme chaque test en insight documenté qui nourrit les suivants.

3. Négliger la durée et la méthodologie des tests

Même avec une bonne hypothèse et une priorisation claire, un test mal mené perd toute crédibilité. Durée trop courte, timing inadapté ou manipulations en cours de route : autant d’erreurs qui faussent la validité statistique et mènent à des décisions trompeuses.

Arrêter un test trop tôt est l’erreur la plus répandue. Une variation peut sembler “gagnante” après quelques jours alors que l’échantillon est insuffisant. Le biais est alors garanti. À l’inverse, prolonger un test au-delà du nécessaire expose aux fluctuations saisonnières, aux campagnes marketing ou aux promotions, qui viennent brouiller les résultats.

Un autre travers est de ne pas exposer toutes les variantes en parallèle. Si l’une d’elles reçoit un trafic différent ou tombe sur une période atypique, le biais temporel invalide l’expérimentation. De même, modifier le test en cours (changer une variation, ajuster le trafic, mettre en pause) compromet sa valeur scientifique.

La bonne pratique est de définir en amont la taille d’échantillon et la durée nécessaires pour atteindre le niveau de confiance souhaité. Ce cadre garantit que les résultats reposent sur une base solide et peuvent être utilisés pour orienter les décisions.

Respecter la rigueur scientifique de l’expérimentation

Pour fiabiliser les enseignements :

- calculez la taille d’échantillon en fonction du niveau de confiance et de la puissance statistique ;

- attendez la fin du test et l’atteinte des seuils prévus avant de tirer des conclusions ;

- prenez en compte l’effet de nouveauté et le délai de réflexion, surtout pour les conversions à cycle long (inscription, achat impliquant un panier élevé).

Appliquer cette rigueur protège vos décisions des biais, évite les faux apprentissages et transforme vos tests en véritables leviers de progression durable. Pour que cette discipline soit pleinement exploitable, il est essentiel de structurer et de documenter chaque expérimentation : sans suivi systématique, même les tests les mieux conçus peuvent perdre leur valeur et conduire à des répétitions inutiles.

4. Tester sans roadmap ni documentation

Un programme d’A/B testing perd vite en efficacité s’il n’est pas soutenu par une documentation claire et centralisée. Trop d’équipes lancent des expérimentations sans garder de trace précise : hypothèse initiale, variantes testées, métriques observées, décisions prises. Le risque est double : répéter les mêmes erreurs ou, pire, ignorer des enseignements précieux déjà obtenus.

Construire un historique des tests permet de capitaliser sur chaque expérience, même lorsqu’elle n’apporte pas de “gagnant” immédiat. Les échecs documentés sont tout aussi riches que les succès, car ils évitent de retenter inutilement des pistes non concluantes et enrichissent la compréhension collective du parcours client.

Formaliser ce processus est essentiel. Mettre en place un modèle standard de fiche de test et un espace partagé (notion, drive, ou outil spécialisé) garantit la transmission des connaissances entre équipes marketing, produit et tech. Cette discipline crée un socle commun qui rend l’A/B testing reproductible, cumulatif et beaucoup plus stratégique dans la durée.

5. Optimiser pour les mauvais KPI

Un A/B testing ne porte ses fruits que si les indicateurs suivis traduisent véritablement la valeur générée par vos actions. Il est tentant de s’appuyer sur des micro-conversions comme des clics ou des ajouts au panier, mais si elles ne sont pas judicieusement choisies ou si elles sont isolées des objectifs métier, leur amélioration peut s’avérer contre-productive.

Néanmoins, les micro-conversions peuvent s’avérer très pertinentes lorsqu'elles sont bien maîtrisées. Elles sont particulièrement utiles pour détecter des opportunités rapides d’optimisation ou lorsqu’on manque de trafic suffisant pour mesurer des impacts sur les macro-conversions (achats, revenus). Par exemple, Kodak GTCI a utilisé Webyn pour améliorer le passage à la page de livraison : en clarifiant le libellé du bouton, l’équipe a réduit l’hésitation des utilisateurs et stimulé un flux plus régulier vers l’étape suivante, un micro-KPI dont l’amélioration a eu un impact concret sur la conversion finale.

La distinction entre micro- et macro-conversions reste essentielle : les premières signalent l’engagement utilisateur, les secondes traduisent la génération de chiffre d’affaires. Il est donc impératif de maintenir un lien clair entre les micro-indicateurs et les objectifs stratégiques, notamment en analysant la qualité du trafic généré et en évitant de se laisser guider par un gain superficiel.

Choisir les métriques alignées avec la stratégie e-commerce

Pour garantir une véritable création de valeur :

- Prioriser la conversion finale, le panier moyen et la Customer Lifetime Value (CLV).

- Adapter les KPIs en fonction du parcours testé : taux de validation du panier, revenus générés, réachat, etc.

- Utiliser les micro-conversions comme outils d’analyse intermédiaire lorsqu’on en maîtrise le sens et que leur amélioration est alignée avec les résultats attendus.

6. Interpréter ou manipuler les résultats de manière erronée

Un A/B test n’est utile que si ses résultats sont analysés avec rigueur et transparence. Pourtant, il est fréquent que les équipes biaisent inconsciemment l’interprétation des données pour confirmer leurs intuitions ou valider la variante qu’elles “préféraient” dès le départ. Céder à ce biais de confirmation mène à des optimisations basées sur des croyances plutôt que sur des preuves.

Un autre piège courant est d’écarter les résultats jugés “décevants” ou ambigus. Un test non significatif n’est pas un échec : il indique simplement que l’hypothèse n’était pas assez solide ou que l’impact mesuré est trop faible pour être détecté. Dans ce cas, mieux vaut documenter l’expérience et planifier un nouveau test que tirer des conclusions hâtives.

Il est également essentiel de distinguer la significativité statistique de la pertinence business. Une amélioration de 1 % sur un micro-KPI peut être significative sur le plan statistique sans pour autant avoir d’impact réel sur les ventes ou la marge. À l’inverse, un signal moins net mais orienté vers une macro-conversion stratégique mérite parfois d’être creusé.

Enfin, attention à ne pas surinterpréter des segments trop petits ou à extrapoler des comportements non prévus initialement. L’A/B testing reste une discipline scientifique : seule une lecture honnête et disciplinée permet d’en faire un levier fiable de croissance.

7. Ne pas prendre en compte les effets secondaires et contextuels

Un test A/B ne se déroule jamais dans un environnement neutre : le contexte influence fortement les résultats. Ignorer ces effets secondaires revient à attribuer à la variation des impacts qui proviennent en réalité de facteurs externes.

L’un des biais les plus fréquents est l’effet de nouveauté. Lorsqu’une modification est mise en ligne, les visiteurs réagissent souvent différemment dans les premiers jours simplement parce qu’ils remarquent un changement. Ces variations initiales doivent être interprétées avec prudence et replacées dans la durée.

De la même manière, les saisons, les promotions, ou encore des événements externes (soldes, jours fériés, actualités fortes) peuvent fausser la lecture d’un test. Sans prise en compte de ces variables, une variante peut sembler performante alors qu’elle profite simplement d’un contexte particulier.

Il est aussi essentiel de tenir compte du time lag, c’est-à-dire du délai entre l’exposition à une variation et la conversion effective. Certains comportements nécessitent plusieurs visites avant de se concrétiser, notamment pour des paniers élevés ou des services B2B. Enfin, segmenter l’analyse entre nouveaux visiteurs et clients récurrents permet de révéler des dynamiques parfois opposées, invisibles dans une lecture globale.

8. Utiliser des outils inadaptés ou mal configurés

Le choix de la solution d’A/B testing et sa configuration sont déterminants pour la fiabilité et l’efficacité de vos tests. Un outil inadapté ou mal paramétré peut fausser les résultats et générer de faux apprentissages.

Il est crucial de vérifier la compatibilité de l’outil avec votre stack technique et le volume de trafic de votre site. Certains outils ralentissent le chargement des pages ou perturbent l’expérience utilisateur, ce qui peut biaiser les comportements observés.

Le paramétrage précis est également essentiel : segmentation des visiteurs, split de trafic et suivi des conversions doivent être configurés correctement pour que les données soient exploitables. Enfin, maintenir vos outils à jour permet de tirer parti des dernières fonctionnalités, comme l’IA, la personnalisation avancée ou l’analyse prédictive, et ainsi optimiser la qualité de vos tests.

9. Arrêter de tester ou tester inutilement

L’A/B testing est un levier continu d’optimisation, c'est un marathon. S’arrêter trop tôt ou lancer des tests sans réelle valeur stratégique gaspille du temps, des ressources et du potentiel de croissance.

Une culture du test continu est essentielle pour rester compétitif. Chaque cycle d’itération doit être guidé par une priorisation claire : éviter de tester des éléments à faible impact business et concentrer les efforts sur ce qui peut réellement influencer les conversions ou le chiffre d’affaires.

Savoir quand arrêter ou renouveler un test est également clé. Certaines expériences nécessitent d’être prolongées, tandis que d’autres doivent être abandonnées ou ajustées pour aller plus loin. Identifier les axes prioritaires à chaque itération transforme l’A/B testing en un moteur durable d’insight et de performance.

Choisissez Webyn pour ne plus vous tromper

Webyn transforme l’A/B testing en un processus simple, fiable et stratégique. Grâce à l’IA, la solution automatise l’analyse des performances, vous aide à formuler des hypothèses pertinentes et garantit le suivi rigoureux des tests.

Vous pouvez prioriser les expérimentations selon leur impact réel sur les conversions et le chiffre d’affaires, tout en évitant les erreurs fréquentes liées aux mauvais KPI, aux outils mal configurés ou aux biais méthodologiques. Avec Webyn, chaque test devient un apprentissage clair, cumulatif et directement exploitable pour accélérer votre croissance.

.svg)

.svg)